两名开发人员使用OpenAI的DALL-E 2图像生成模型创建了一个法医素描程序,该程序可以根据用户输入创建“超逼真”的嫌疑人警察素描。

该程序名为Forensic Sketch AI-rtist,由开发人员Artur Fortunato和Filipe Reynaud创建,是2022年12月黑客马拉松的一部分。根据上传到互联网上的一份演示,开发人员写道,该程序的目的是缩短通常抓获犯罪嫌疑人所需的时间,“大约两到三个小时”。

“我们还没有发布这款产品,所以目前还没有任何活跃用户,”Fortunato和Reynaud在一封联合电子邮件中告诉Motherboard。“在这个阶段,我们仍在尝试验证这个项目是否可以在现实世界中使用。为此,我们计划与警察部门联系,以便获得我们可以测试的输入数据。”

人工智能伦理学家和研究人员告诉Motherboard,在警察取证中使用生成式人工智能是非常危险的,有可能恶化最初证人描述中出现的现有种族和性别偏见。

“传统法医草图的问题不在于它们需要时间来制作(这似乎是这个AI法医草图程序试图解决的唯一问题)。问题是,任何法医素描都已经受到人类偏见和人类记忆的弱点的影响,”电子前沿基金会的监视诉讼主管詹妮弗·林奇告诉Motherboard。“人工智能无法解决这些人类问题,而这个特殊的程序可能会通过其设计使问题变得更糟。”

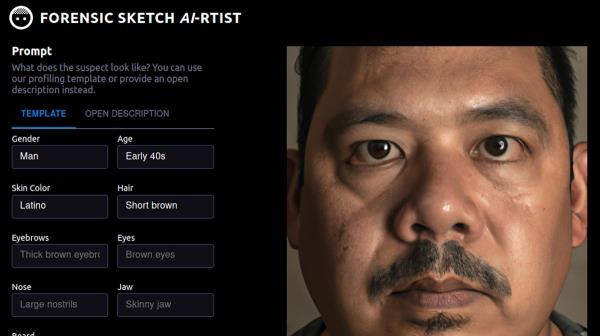

该程序要求用户通过要求性别、肤色、眉毛、鼻子、胡须、年龄、头发、眼睛和下巴描述的模板提供信息,或者通过开放描述功能提供信息,用户可以输入他们对嫌疑人的任何描述。然后,用户可以点击“generate profile”,将描述发送到dall - e2,并生成人工智能生成的肖像。

“研究表明,人类对面孔的记忆是整体的,而不是逐个特征。依赖于个人特征描述的素描过程,比如这个人工智能程序,可以得出一张与犯罪者截然不同的脸,”林奇说。“不幸的是,一旦目击者看到合成物,那张照片可能会取代他们对实际嫌疑人的模糊记忆。人工智能生成的图像看起来比手绘草图更‘真实’,这只会加剧这种情况。”

创建类似无辜者的超现实主义嫌疑人档案对黑人和拉丁美洲人尤其有害,黑人被警察无故拦下的可能性是白人的五倍。有色人种也更有可能被拦截、搜查和怀疑犯罪,即使没有发生犯罪。

林奇说:“如果这些人工智能生成的法医素描被公开,它们可能会强化刻板印象和种族偏见,并将注意力转移到长得像素描的人而不是真正的犯罪者身上,从而阻碍调查。”他补充说,在美国,错误的目击者指认导致了69%的错误定罪,这些错误定罪后来被DNA证据推翻。总的来说,虚假或误导性的法医鉴定——包括警方的素描——在美国所有错误定罪中占了近25%。在本已不可靠的证人描述过程中加入dall - e2使问题恶化。HuggingFace的研究科学家Sasha Luccioni在推特上发布了关于警察素描程序的消息,她告诉Motherboard, DALL-E 2包含许多偏见——例如,当被要求生成首席执行官的图像时,它显示的主要是白人男性。Luccioni说,尽管这些例子反复出现,但我们仍然无法确定模型偏差的确切来源,因此无法采取正确的措施来纠正它们。OpenAI不断开发方法来减轻其人工智能输出中的偏见。

“通常情况下,由于数据集中存在的偏见,由于缺乏监督,因为互联网上有很多有色人种的代表已经非常种族主义,非常不公平,这些技术已经更加边缘化了。这就像是一种复合因素,”Luccioni补充道。与其他人工智能专家一样,她将这一过程描述为一个反馈循环,其中人工智能模型包含、产生并延续偏见,因为它们生成的图像将继续被使用。

福尔图纳托和雷诺说,他们的程序运行的前提是,警察的描述是可信的,“警察应该负责确保分享公平诚实的素描。”

开发人员说:“任何由它产生的不一致都应该手动或自动(通过要求更改)纠正,最终的图纸是艺术家自己的作品,由EagleAI和目击者协助完成。”“这款产品的最终目标是生成最逼真的嫌疑人画像,任何错误都应该被纠正。此外,该模型很可能不会在一次尝试中产生理想的结果,因此需要迭代才能获得可能的最佳结果。”

开发人员自己也承认,没有衡量生成图像准确性的标准。在刑事案件中,在找到嫌疑人或已经在监狱服刑之前,不准确的信息可能无法更正。就像警方在社交媒体上分享嫌疑人的姓名和照片一样,在此之前分享不准确的照片也可能会让已经过度犯罪的人群产生怀疑。批评人士还指出,开发商对警察中立的假设忽视了充分记录在案的证据,即警察在刑事案件中出示证据和作证时经常撒谎。

福尔图纳托和雷诺的人工智能工具并不是第一个因生成嫌疑人图像而引发争议的软件。2022年10月,埃德蒙顿警察局(EPS)分享了一张用DNA表型创建的计算机生成的嫌疑人图像,引起了隐私和刑事司法专家的强烈反对,该部门从其网站和社交媒体上删除了这张照片。再一次,在传播一张看似真实的照片时缺乏准确性,将无辜的人置于危险之中。“我优先考虑调查,在这种情况下,调查涉及为受害者伸张正义,她本人是一个种族化社区的成员,而不是对黑人社区的潜在伤害。这是一种不可接受的交易,我为此道歉,”EPS首席运营官埃尼纳?奥克尔(Enyinnah Okere)在遭到强烈反对后的一份新闻稿中写道。

去年,隐私与技术中心(Center on Privacy & Technology)的一份报告发现,人工智能面部识别工具经常会导致司法案件中的偏见和错误。该报告指出,面部识别是一种不可靠的身份证据来源,人脸识别搜索中的算法和人为步骤可能会加剧其他人的错误。报告称:“由于人脸包含固有的偏见信息,如人口统计数据、表情和假定的行为特征,因此可能不可能消除偏见和错误的风险。”

“我认为,随着这项技术的成熟,我们应该开始制定这些模型能做和不能做的事情的规范。所以对我来说,这个法医素描师显然是我们不应该使用生成技术的。”Luccioni说。“因此,无论我们多么了解模型中的偏差,都有一些应用不应该被使用。”

OpenAI拒绝就其技术在福尔图纳托和雷诺项目中的使用发表评论。

微信扫一扫打赏

微信扫一扫打赏